設(shè)計網(wǎng)站做多大合適搜狗seo查詢

Olllama

直接下載ollama程序,安裝后可在cmd里直接運(yùn)行大模型;

llama 3

meta 開源的最新llama大模型;

下載運(yùn)行

1 ollama

ollama run llama3

2 github

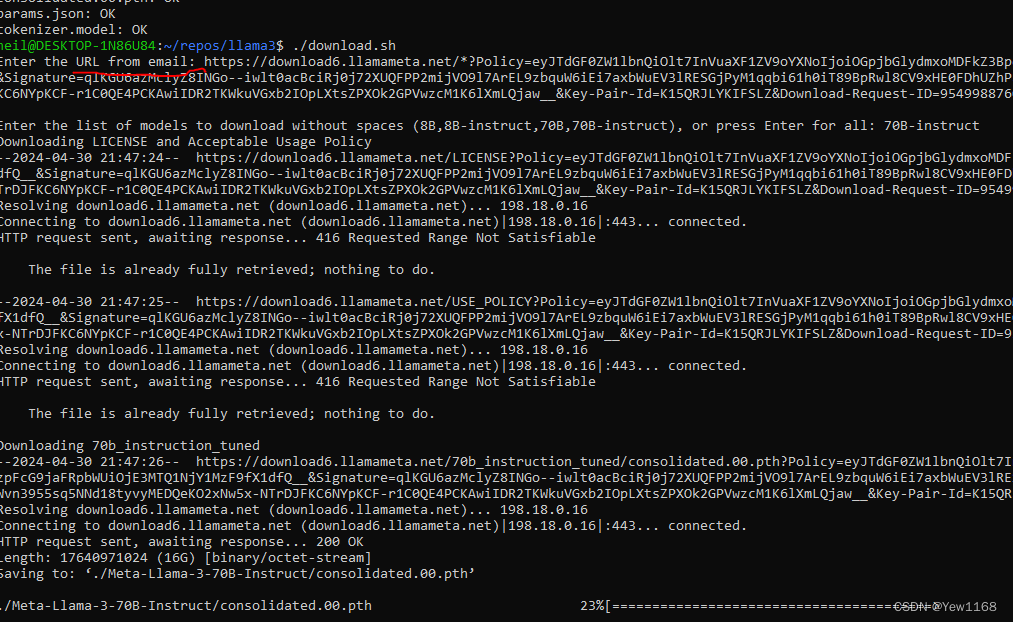

下載倉庫,需要linux環(huán)境,windows可使用wsl;

- 接受許可協(xié)議。獲取下載鏈接

- 倉庫運(yùn)行download.sh

3.quickstart

3 huggingface

meta

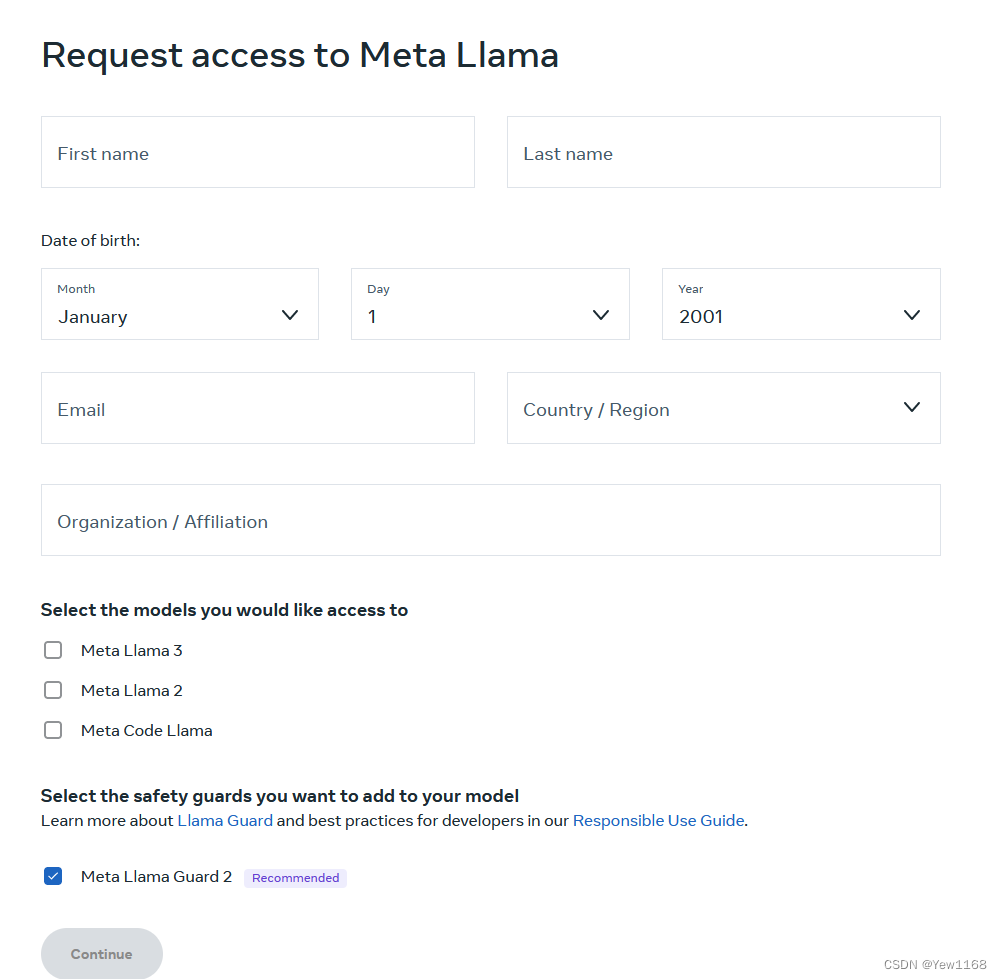

接受協(xié)議,訪問模型文件,(不知道是不是affiliation填none被拒絕了)

補(bǔ)充

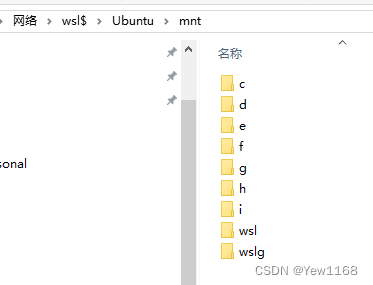

1.windows訪問wsl文件

\\wsl$

查看文件

2. wsl訪問windows

lwsl文件系統(tǒng)mnt已掛載windows盤符,不過需要在linux 里(terminal)訪問,使用cp復(fù)制等。

3. 使用ip網(wǎng)絡(luò)傳輸文件

#wsl terminal

#查看IP地址

ip addr

# 復(fù)制windows文件至wsl

scp [-r] file/dir hostname@ip_addr:/home/ # windows terminal

scp [-r] hostname@ip_addr:/home/ D:\rev

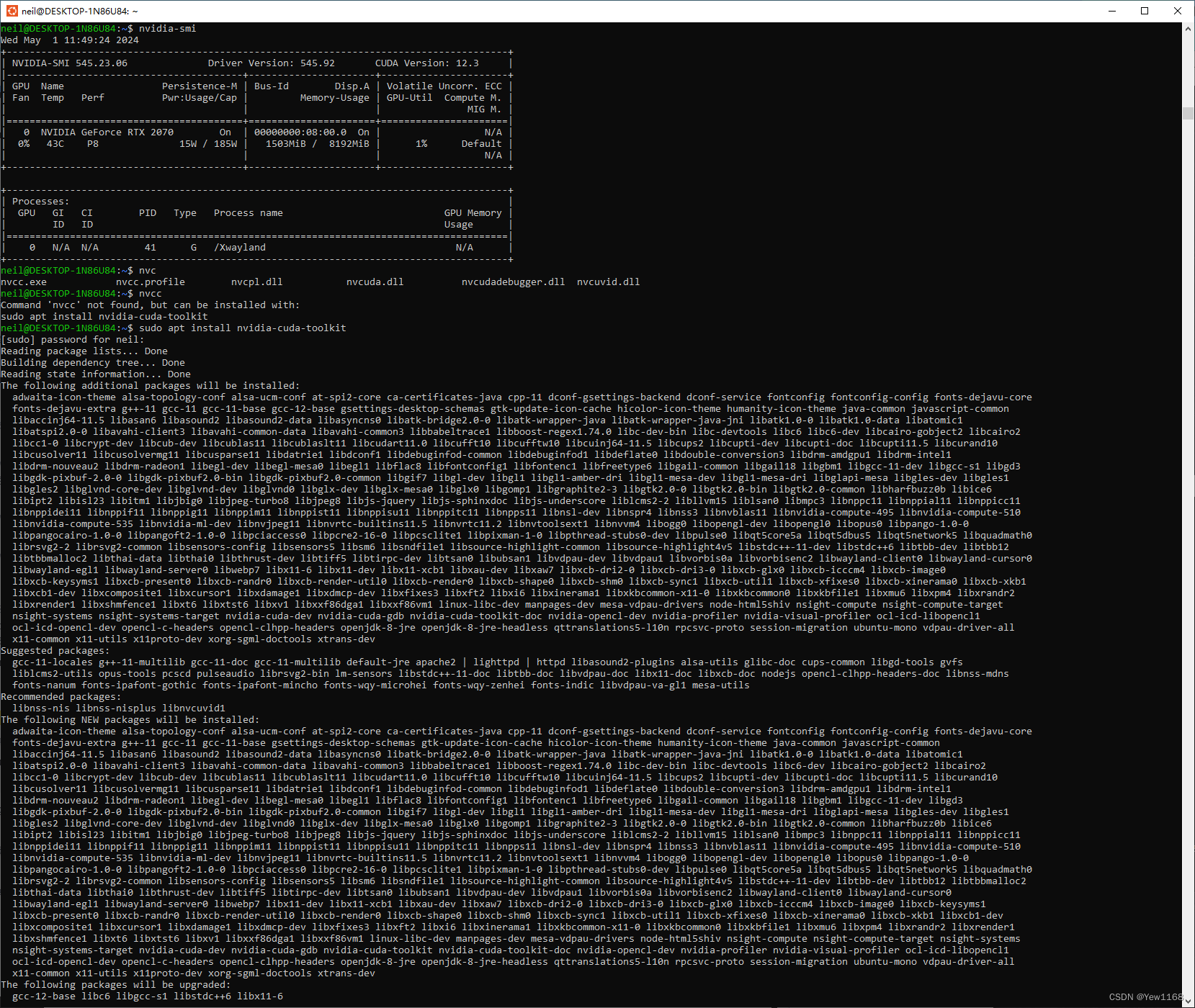

- wsl nvidia cuda

似乎默認(rèn)能直接訪問gpu,但cuda還需安裝nvidia-cuda-toolkit

5.模型后綴

Instruct is fine-tuned for chat/dialogue use cases.

Example: ollama run llama3 / ollama run llama3:70b

Pre-trained is the base model.

Example: ollama run llama3:text / ollama run llama3:70b-text